AI-компании призывают оценить угрозу сверхинтеллекта, чтобы избежать потери контроля человеком

Категория: Business,

2025-05-10 11:15

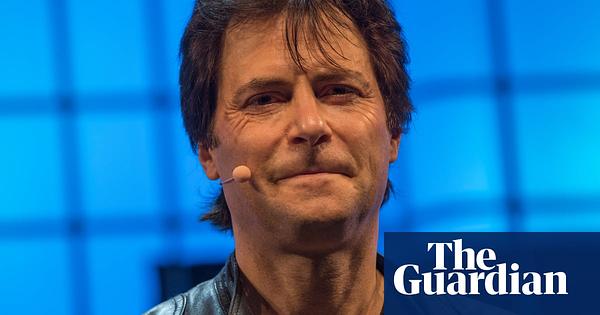

Компании, занимающиеся искусственным интеллектом, призывают провести тщательные оценки безопасности — аналогичные тем, что проводились перед первым ядерным испытанием — чтобы оценить экзистенциальные риски, связанные с развитием ИИ. Макс Тегмарк, известный сторонник безопасности ИИ, предупреждает, что без таких расчетов существует опасность выхода сверхинтеллектуальных систем из-под человеческого контроля.

Компании, разрабатывающие искусственный интеллект (ИИ), настоятельно призывают проводить комплексные расчеты безопасности перед выпуском высокоразвитых ИИ-систем, так называемых 'сверхинтеллектов'. С таким заявлением выступил Макс Тегмарк — известный физик и активист в области безопасности ИИ, который проводит аналогию с мерами предосторожности, предпринятыми Робертом Оппенгеймером и его командой перед первым ядерным испытанием в 1945 году. Тогда команда Оппенгеймера рассчитала вероятность того, что ядерный взрыв может воспламенить атмосферу Земли, и только убедившись в безопасности, приступила к испытанию. Тегмарк считает, что компании, создающие ИИ, должны проявлять не меньшую осторожность и проводить оценки экзистенциальных рисков, чтобы убедиться, что будущие ИИ-системы не получат возможности действовать вне контроля человека. Опасения связаны с тем, что по мере усложнения ИИ он может принимать решения и совершать действия, которые человек не сможет предсказать или контролировать, что может привести к непредвиденным и, возможно, катастрофическим последствиям. Эта позиция отражает более широкий дискурс в технологической отрасли и среди политиков о необходимости сбалансировать быстрые темпы развития ИИ с внедрением надежных протоколов безопасности. В статье подчеркивается важность регулирования, прозрачности и этической ответственности разработчиков ИИ, а также необходимость заблаговременных мер безопасности для предотвращения сценариев, при которых ИИ может представлять угрозу для человечества.

Источник: The Guardian

Важность: 80%

Интерес: 85%

Достоверность: 92%

Пропаганда: 10%