Advierten a empresas de IA que evalúen la amenaza de la superinteligencia o arriesgan perder el control humano

Categoría: Business,

2025-05-10 11:15

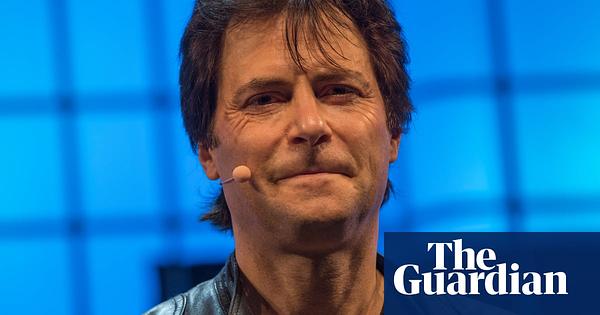

Se insta a las empresas de inteligencia artificial a realizar evaluaciones rigurosas de seguridad —similares a las que precedieron la primera prueba nuclear— para valorar los riesgos existenciales de sistemas de IA avanzados. Max Tegmark, destacado defensor de la seguridad en IA, advierte que, sin estos cálculos, existe el peligro de que sistemas superinteligentes escapen al control humano.

Las empresas que desarrollan inteligencia artificial (IA) han sido instadas a llevar a cabo cálculos de seguridad exhaustivos antes de lanzar sistemas de IA altamente avanzados, conocidos como 'superinteligentes'. Esta advertencia proviene de Max Tegmark, físico y reconocido activista por la seguridad en IA, quien compara la situación actual con las precauciones tomadas por Robert Oppenheimer y su equipo antes de la primera prueba nuclear en 1945. En aquel entonces, el equipo de Oppenheimer evaluó la posibilidad de que la explosión nuclear pudiera encender la atmósfera terrestre, un riesgo catastrófico, y solo procedieron tras concluir que era seguro. Tegmark sostiene que las empresas de IA deben mostrar un nivel de precaución similar, realizando evaluaciones de riesgos existenciales para garantizar que los futuros sistemas de IA no desarrollen capacidades que les permitan actuar fuera del control humano. La preocupación es que, a medida que la IA se vuelve más poderosa, podría tomar decisiones o realizar acciones impredecibles para los humanos, con consecuencias potencialmente graves. Esta advertencia se enmarca en el debate más amplio dentro de la industria tecnológica y entre los responsables políticos sobre cómo equilibrar el rápido desarrollo de la IA con la necesidad de protocolos de seguridad sólidos. El artículo resalta la importancia de la regulación, la transparencia y la responsabilidad ética de los desarrolladores de IA, subrayando la necesidad de medidas preventivas para evitar escenarios en los que la IA pueda representar una amenaza para la humanidad.

Fuente: The Guardian

Importancia: 80%

Interés: 85%

Credibilidad: 92%

Propaganda: 10%